Компания Stability AI выпустила предварительную версию Stable Diffusion 3.0 – флагманскую модель искусственного интеллекта следующего поколения для генерации изображений по текстовому описанию. Stable Diffusion 3.0 будет доступна в разных версиях на базе нейросетей размером от 800 млн до 8 млрд параметров.

Источник изображений: Stable Diffusion 3.0

В течение последнего года Stability AI постоянно совершенствовала и выпускала несколько нейросетей, каждая из которых показывала растущий уровень сложности и качества. Выпуск SDXL в июле значительно улучшил базовую модель Stable Diffusion, и теперь компания намерена пойти гораздо дальше.

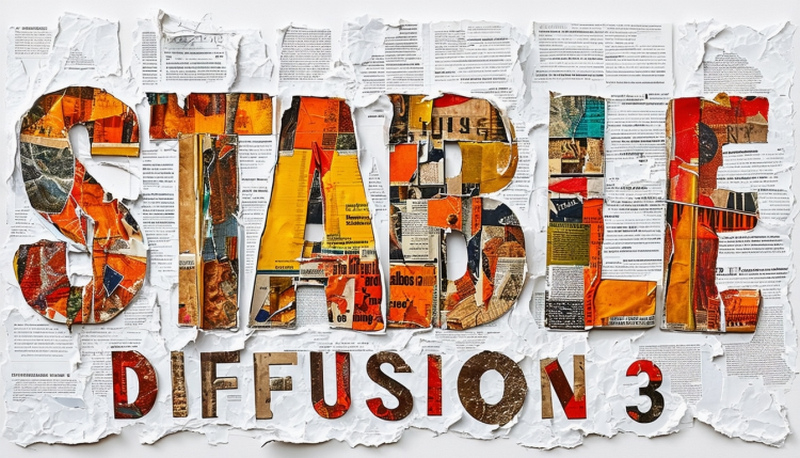

Новая модель Stable Diffusion 3.0 призвана обеспечить улучшенное качество изображения и лучшую производительность при создании сложных подсказок. Новая нейросеть обеспечит значительно лучшую типографию, чем предыдущие версии Stable Diffusion, обеспечивая более точное написание текста внутри сгенерированных изображений. В прошлом типография была слабой стороной Stable Diffusion, собственно, как и многих других вторых художников.

Stable Diffusion 3.0 – это не просто новая версия модели бывшей Stability AI, ведь она основана на новой архитектуре. «Stable Diffusion 3 – это диффузионная модель-трансформер, архитектура нового типа, аналогичная той, что используется в представленной недавно модели OpenAI Sora, – рассказал VentureBeat Эмад Мостак (Emad Mostaque), генеральный директор Stability AI. – Это настоящий преемник оригинальной Stable Diffusion».

Stability AI экспериментирует с несколькими типами подходов к созданию изображений. Ранее в этом месяце компания выпустила предварительную версию Stable Cascade, использующую архитектуру Würstchen для повышения производительности и точности. Stable Diffusion 3.0 использует другой подход, используя диффузионные модели-трансформеры. «Ранее у Stable Diffusion не было трансформера», – сказал Мостак.

Трансформеры лежат в основе большинства современных нейросетей, запустивших революцию в области искусственного интеллекта. Они широко используются в качестве основы моделей генерации текста. Генерация изображений в основном находилась в области диффузных моделей. В исследовательской работе, в которой подробно описываются диффузионные трансформеры (DiT), объясняется, что это новая архитектура для диффузионных моделей, которая заменяет магистраль, широко используемый U-Net трансформером, работающим на скрытых участках изображения. Применение DiT позволяет более эффективно использовать вычислительные мощности и превосходить другие подходы к диффузному генерированию изображений.

Еще одна важная инновация, которой пользуется Stable Diffusion 3.0, – это согласование потоков. В исследовательской работе по сопоставлению потоков объясняется, что это новый метод обучения нейросетям с помощью “непрерывных нормализующих потоков” (Conditional Flow Matching – CNF) для моделирования сложных распределений данных. По мнению исследователей, использование CFM с оптимальными путями транспортировки приводит к более быстрому обучению, более эффективному отбору образцов и повышению производительности по сравнению с диффузионными путями.

Улучшенная типография Stable Diffusion 3.0 является результатом нескольких улучшений, которые Stability AI встроил в новую модель. Как пояснил Мостак, качественная генерация текстов на изображение стала возможной благодаря использованию диффузионной модели-трансформера и дополнительных кодировщиков текста. С помощью Stable Diffusion 3.0 стало возможным генерировать на изображениях полные предложения со связным стилем написания текста.

Хотя Stable Diffusion 3.0 изначально демонстрируется как технология искусственного интеллекта для преобразования текста в изображение, она станет основой гораздо большего. В последние месяцы Stability AI также создаст нейросети для создания 3D-изображений и видео.

«Мы создаем открытые модели, которые можно использовать где угодно и адаптировать к любым потребностям.– сказал Мостак. – Это серия моделей разных размеров, которая станет основой для разработки наших визуальных моделей следующего поколения, включая видео, 3D и многое другое». #! MARKER#!